Get Complete Project Material File(s) Now! »

Variabilité inter-individuelle dans une tâche d’autoshaping

Utilisant une procédure de conditionnement Pavlovien, où un levier est présenté pendant 8 secondes, suivi immédiatement après par une distribution de nourriture dans un ma-gasin adjacent, Flagel et al. [Fla+11b] ont observé une forte variabilité dans les réponses induites chez des rats. Certains rats (sign-trackers ; ST) développent rapidement une ré-ponse d’approche suivi du grignotement du levier, bien que cela ne soit pas nécessaire à la distribution de nourriture. D’autres rats (goal-trackers ; GT), développent une ap-proche similaire mais vers la mangeoire (Figure 2). Ils ont de plus constaté que l’activité dopaminergique enregistrée dans le cœur du nucleus accumbens différait selon les rats. Chez les ST, cette activité est conforme à la littérature actuelle sur le sujet, avec un pic d’activité à l’apparition de la nourriture qui au cours de temps se déplace à l’apparition du levier [Sch+97]. De plus, toute interruption du fonctionnement de la dopamine (e.g. par l’injection de drogues) empêche le développement de ce type de comportement. Chez les GT, au contraire, l’activité est différente, le pic de dopamine n’est pas propagé et un second apparaît à l’apparition du levier. De plus, l’acquisition du comportement ne semble pas sensible au blocage de la dopamine.

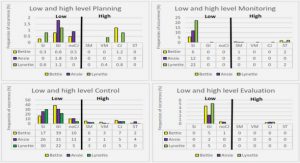

Figure 2 – Reproduction des différences de comportement dans une population de rats réalisant une expérience d’autoshaping. Probabilité moyenne de s’engager au moins une fois avec le levier (A,C) ou le magasin (B,D) pendant les essais. Les données sont exprimées en moyennes ± SEM et regroupées par blocs de 50 essais (2 sessions). (A,B) Reproduction des résultats expérimentaux de Flagel et al. [Fla+09] (Figure 2 A,B). Les sign-trackers (ST) appuient le plus sur le levier (noir), les goal-trackers (GT) appuient le moins sur le levier (gris), et le groupe intermédiaire (IG) est entre les deux (blanc). (C,D) Simulation de la même procédure (carrés) avec le modèle informatique. Les rats simulés sont répartis entre ST (ω = 0.499) en rouge, GT (ω = 0.048) en bleu et IG (ω = 0.276) en blanc. Le modèle reproduit les même différences comportementales. Avec de l’entraînement, les ST s’engagent de plus en plus vers le levier et de moins en moins vers le magasin, alors que les GT négligent le levier au profit d’un engagement croissant vers le magasin. Les IG oscillent entre les deux.

Ces données posent problème aux modèles actuels du conditionnement Pavlovien [Cla+12] qui ne rendent souvent compte que d’un seul type de comportement à la fois et d’un seul type de réponse. Elles posent également problème à d’autres modèles qui s’appuieraient essentiellement sur le cadre de l’apprentissage par renforcement classique. Dans [Les+14b] nous comparons notre modèle à ces modèles plus classiques et montrons qu’il est le seul à même de rendre compte des diverses données expérimentales collectées autour de cette expérience [Fla+09; Fla+11b; Fla+07; RF09; Mey+12] (Figure 3).

Figure 3 – Synthèse des simulations. Chaque ligne représente un modèle différent composé d’une paire de systèmes d’apprentissage par renforcement. Chaque colonne représente une ex-périence simulée. Les expériences sont groupées par le type de données expérimentales qu’elles impliquent : comportementales (autoshaping [Fla+09; Fla+11b], CRE [RF09], Incentive sa-lience [MB09; DB12b]), physiologique [Fla+09] et pharmacologique (Flu post-NAcC [SR12], Flu pre-systemic [Fla+09]).

Nous modélisons l’expérience décrite avec le MDP illustré en Figure 4. L’agent com-mence dans un état vide (s0) où il n’y a rien d’autre à faire qu’explorer. A un certain moment, le levier apparaît (s1) et l’agent doit faire un choix : il peut s’engager avec le levier (s2) et interagir avec, s’engager vers le magasin (s4) et interagir avec, ou continuer à explorer (s3, s6). A un certain moment, le levier est rétracté et de la nourriture est dé-livrée. Si l’agent est loin du magasin (s5,s6), il doit d’abord s’en approcher. Une fois prêt (s7), il mange la nourriture. Il finit dans un état vide (s0) qui symbolise le début de la période de repos entre deux essais (ITI) : pas de nourriture, pas de levier et un magasin toujours présent mais vide. Le même MDP et le même jeu de paramètres est utilisé pour toutes les expériences, i.e. notre modèle peut faire le lien entre des données physiologiques et l’expression d’un comportement.

Aussi, notre modèle explique la différence entre les ST et le GT par une pondération différente dans la contribution des systèmes MB et FMF (Figure 2). Les ST se reposent principalement sur le système FMF, tandis que les GT se reposent principalement sur le système MB. De plus, cette différence se retrouve au niveau du signal de prédiction d’erreur δ du système FMF que l’on peut alors de nouveau mettre en parallèle avec les données dopaminergiques, et ainsi résoudre le conflit que ces données présentaient par rapport à la littérature actuelle. Nous faisons la proposition que certains signaux dopa-minergiques peuvent encoder une erreur de prédiction calculée sur des stimuli individuels – apparition du levier. L’état initial est doublement cerclé, l’état final est représenté en pointillé et termine l’épisode courant. Les actions sont : s’engager avec le stimulus le plus proche (eng), explorer (exp), s’approcher (go) du magasin ou du levier ou manger (eat). Pour chaque action, l’élément central à l’action est présenté entre crochets. Le chemin que les ST devraient préférer est en rouge. Le chemin que les GT devraient préférer est en bleu pointillé. (B) Chronologie correspondant au déroulement du MDP.

et non des situations globales. Pour finir, cette différence de contribution dans les deux systèmes explique également pourquoi le comportement des GT ne semble pas affecté par l’injection de flupentixol, un antagoniste de la dopamine, alors que celui des ST est bloqué tant dans son acquisition que son expression.

Dans une procédure presque similaire à celle utilisée par [Fla+11b] mais avec une touche lumineuse à la place du levier, et tout contact avec cette touche entraînant une omis-sion de la distribution de la nourriture, Williams and Williams [WW69] ont montré que certains pigeons étaient incapables de s’empêcher de becqueter cette touche malgré son effet néfaste. De plus, d’autres résultats semblent indiquer que tous les pigeons ne sont pas incapables d’apprendre à retenir leurs coups de becs [San+06], suggérant ici aussi une variabilité dans les réponses observées pour une même tâche dans différent individus de la même espèce. Dans l’expérience de Williams and Williams [WW69], divers protocoles mettent en valeur que, bien qu’incapables de se refréner de becqueter, les pigeons sont capables dans une certaine mesure de choisir vers quel élément saillant ils dirigent leurs coups de bec.

Ces données posent une fois de plus problème à la littérature classique, avec plusieurs réponses tournées vers plusieurs cibles, et une variabilité inter-individuelle difficilement explicable par un seul système. Dans [Les+14a] nous confirmons que notre modèle est capable d’expliquer également ce jeu de données sans modifications.

Le problème est presque identique à celui sur la tâche d’autoshaping de Flagel et al. [Fla+11b] (Figure 5). Nous avons remplacé dans le MDP précédent le levier par une touche lumineuse, et rajouté la possibilité, ici nécessaire, de se réfréner d’agir (ngo) une fois proche d’un stimulus. Le contact (eng) avec la touche lumineuse amenant directement au début de la période de repos (ITI) sans obtention de la récompense. D’autres MDP similaires ont été utilisés pour les différents protocoles, en rajoutant d’autres chemins pour d’autres leviers.

Figure 5 – Représentation informatique de la procédure de negative automainte-nance. MDP représentant l’expérience 1 de Williams and Williams [WW69] et du protocole Brief PA de Sanabria et al. [San+06]. Les états sont représentés par un jeu de variables : K/F – touche lumineuse négative/nourriture est disponible (le magasin est toujours disponible, même s’il n’est pas montré), cM/cK – proche du magasin/touche lumineuse, Ka – apparition de la touche lumineuse. L’état initial est doublement cerclé, l’état terminal est représenté en pointillé et termine l’épisode courant. Les actions sont : s’engager (eng) ou se réfréner de s’engager (ngo) avec le stimulus le plus proche, explorer (exp) ou s’approcher (go) du magasin ou de la touche de lumière, et manger (eat). Pour chaque action, l’élément central à l’action est présenté entre crochets.

Notre modèle arrive à reproduire les données tant de Williams and Williams [WW69] que Sanabria et al. [San+06] avec le même jeu de paramètres, à l’exception principale de la pondération entre les deux systèmes (Figure 6). Ainsi, nous expliquons l’incapacité des pigeons à s’empêcher de becqueter par une forte prépondérance du système MF dans la décision. A l’inverse, les pigeons capables de ne pas toucher la lumière ont une prépon-dérance pour le système MB. Notre modèle explique également la prévalence des stimuli contingents aux récompenses à attirer les coups de becs par rapport à ceux présents tout au long de l’expérience, même dans le cas où l’interaction qui en résulte est néfaste à l’accumulation de récompenses.

Figure 6 – Simulation de l’expérience 1 de Williams and Williams [WW69] et du protocole Brief PA de Sanabria et al. [San+06]. (A) Coup de becs cumulés envers la touche lumineuse négative réalisés par 8 pigeons GT simulés (bleu) et 8 pigeons ST simulés (rouge). La courbe en gris pointillé simule le pire scénario (si les pigeons avaient becqueté la touche lumineuse à chaque essai). Les données sont exprimées en moyenne ± SEM. (B) Agrandissement de (A) pour un meilleure lisibilité de la courbe bleue (GT). (C) Coups de becs cumulés pour un pigeon ST par bloc de 50 essais. A mettre en parallèle avec la Figure 1 de Williams and Williams [WW69]. (D) Coups de becs cumulés pour un pigeon GT par bloc de 50 essais.

De manière plus générale, nous expliquons une fois de plus la variabilité des compor-tements par la seule différence de pondération entre deux systèmes MB et FMF. Nous mettons en évidence que cette collaboration peut effectivement amener à des comporte-ments inadaptés.

Cette thèse présente nos contributions dans la modélisation de certains phénomènes Pav-loviens et instrumentaux à l’aide du cadre de l’apprentissage par renforcement, étendu pour utiliser des représentations factorisées.

Nous expliquons que les variabilités inter-individuelles observées chez les rats [Fla+11b] et les pigeons [WW69; San+06] sont la résultante d’une collaboration de deux systèmes basés sur des principes d’apprentissage par renforcement [Les+14b; Les+de]. Le premier système (MB) évalue les situations rencontrées de manière globale alors que le second système (FMF) traite des éléments indépendants. Ces systèmes ne favorisent donc pas toujours les mêmes actions, et selon la prépondérance accordée à l’un plutôt qu’à l’autre, différents individus peuvent présenter des comportements radicalement différents sur le long terme [Fla+07; Fla+09; RF09; Fla+11b; MB09; DB12b; SR12; Mey+12; Mey+14].

Cette collaboration peut amener à des comportements inadaptés [BB61; Her86; GM+12], comme ceux étudiés chez les pigeons [Les+de]. Nous montrons que l’acquisition d’une cer-taine valeur, source de motivation, par des éléments contingents aux récompenses, peut biaiser de manière permanente le comportement vers des actions néfastes à l’accumulation de récompenses.

Le calcul de la RPE au niveau du système FMF dépend du comportement au niveau du modèle, et peut donc être différente d’un individu à un autre. Nous expliquons ainsi que l’incohérence observée entre l’activité dopaminergique des GT [Fla+11b] et ce qui est attendu par la littérature classique [Sch+97] viendrait de la différence de comportement induite par la différence de pondération entre les deux systèmes et du calcul de la RPE sur des éléments individuels et non sur la situation globale à laquelle les rats sont confrontés.

Pour finir, notre modèle explique l’acquisition d’incentive salience [Ber07; MB09; Ber12] par l’évaluation individuelle de certains éléments saillants. L’attribution d’une valeur propre pour ces éléments, permet alors de biaiser le comportement en favorisant des actions d’approches et d’engagement avec ces derniers.

Jusqu’à présent, nous avons uniquement envisagé l’utilisation de représentations factori-sées dans le système MF de notre architecture. Cependant, rien n’empêcherait d’utiliser de telles représentations dans le système MB. Il serait même surprenant qu’un système se passe de représentations plus riches si elles sont accessibles. Leur utilisation pour-rait cependant être différente dans chaque système. Il existe déjà un certain nombre d’algorithmes MB s’appuyant sur des représentations factorisées [Bou+00; Deg+06; VB08]. Ceux-ci utilisent leur connaissance de la structure du monde pour représenter les fonctions valeurs de manière plus compacte, généraliser certains calculs et ainsi gagner en espace et temps de calculs requis. Ces optimisations ne servent qu’à étendre les algorithmes classiques à de plus gros problèmes, mais ne changent en rien les solutions optimales trou-vées. Aussi, il serait possible de remplacer notre système MB par une version factorisée traditionnelle sans changer les résultats. Cependant, les propriétés de généralisation de ces algorithmes peuvent introduire des comportements en début d’apprentissage qui dif-fèrent des algorithmes classiques, et il serait opportun d’étudier si de tels comportements peuvent être observés chez certains animaux et confirmer l’utilisation de tel algorithmes. Il est aussi à noter qu’à notre connaissance, il n’existe pas de version factorisée des sys-tèmes MF classiques, qui n’ont pas accès à la structure du monde pour en extraire une organisation compacte des valeurs.

Bien que notre modèle soit la combinaison d’un système MB et d’un système MF, il est important de le distinguer des modèles du conditionnement instrumental qui impliquent aussi ces deux aspects [Daw+05; Ker+11; Pez+13], où des études qui suggèrent égale-ment la présence de ces deux composantes dans le Pavlovien [Jon+12; RB13]. Dans le cas instrumental, la combinaison de deux modèles est utilisée pour reproduire la variation des capacités d’un même individu selon certains critères ou expériences (e.g. motivation ou entraînement) [Ott+13; Daw+05; Ker+11; Daw+11; Dol+12; Bei+11]. Dans le cas Pavlovien, il est également question de rendre compte de la capacité d’un même individu à prendre en compte certaines informations passées dans une nouvelle situation [RB13; Jon+12]. Notre modèle au contraire, utilise cette combinaison pour rendre compte de la variabilité de comportement de différent individus dans les mêmes conditions théoriques. Nous pensons avoir ici principalement modélisé les aspects MF du Pavlovien et MB de l’instrumental. Il est à noter que le système FMF se comporte comme un système MF classique dans certains cas (par exemple, pour les ST, il se comporte comme attendu par la théorie classique [Sch+97; Sch98; Sut88]) et on pourrait envisager de l’y substituer dans les modèles utilisant des systèmes MF classiques. Un modèle plus complet pourrait inté-grer les quatre systèmes (MF/MB instrumental et Pavlovien), en s’inspirant des modèles déjà existants, soulevant la question alors importante de savoir comment s’organise leur intégration [Yin+08; Mee+12; LO12; Mee+10; Mai09].

Tous les algorithmes MF reposent sur un signal d’erreur de prédiction, mais ce signal n’est pas forcément calculé de la même manière [SB87; Sut88; WD92; SB98]. Bien que l’hypothèse que la dopamine encode effectivement un signal d’erreur reste assez majoritaire dans la communauté [Sch+97; Sch10; Sch13; Mor+06; Roe+07; Eno+11], il existe un débat quant à son mode de calcul. Certaines études suggèrent un calcul de type “Q-Learning” i.e. on considère que la prochaine action réalisée sera celle avec la valeur la plus élevée [Roe+07], d’autre un calcul de type “SARSA”, i.e. au moment du calcul de la RPE, l’action suivante est déjà choisie et donc prise en compte [Mor+06], cette question est en cours d’investigation et il semble que le problème est plus complexe [Bel+12a; Bel+13]. Nous avons arbitrairement choisi une règle de type “Q-Learning” mais l’autre possibilité reste à explorer. De manière plus générale, la RPE calculée dans notre système FMF repose sur la propagation de valeur entre éléments et non entre états, il n’est donc pas impossible que les données conflictuelles de Morris et al. [Mor+06] et Roesch et al. [Roe+07] puissent résulter de cette différence plus que le type de règle impliqué, car les protocoles de ces deux expériences ne sont pas identiques au niveau de la présentation des stimuli conditionnés. Pour finir, les données de Roesch et al. [Roe+07] suggèrent que l’acquisition du comportement est plus rapide que l’évolution de la dopamine. Notre modèle ne dépendant que partiellement sur le système FMF, en complètement d’un autre système MB supposé plus rapide, pourrait expliquer ces données. Nous n’avons pas encore étudié la dynamique de notre modèle ni les données exploitées sur cet aspect.

Une partie importante de nos résultats s’appuie sur l’hypothèse que la présence d’un stimulus pendant la période de repos entre les essais induit une diminution de la valeur qu’il a pu acquérir pendant la phase de conditionnement [Les+14b; Les+14a; Les+de]. Cette hypothèse explique pourquoi la mangeoire ne serait pas aussi attractive qu’un levier [Fla+11b; RF09], ou qu’une touche lumineuse qui ne s’éteint jamais n’arriverait pas à attirer les coups de becs des pigeons en présence d’une autre touche lumineuse contingente à la distribution de nourriture [WW69]. Des travaux préliminaires semblent montrer que cette dévaluation n’est pas dûe à un quelconque engagement envers ces éléments pendant cette période. Nous avons proposé dans [Les+14a] des protocoles qui permettraient de confirmer que la simple présence en serait la cause. Il serait également possible d’envisager que chaque stimulus diffère dans la valeur qu’il est capable d’acquérir, en fonction de sa forme ou d’autres propriétés [RW72; Mey+14; Hol77], comme certains phénomènes Pavlovien semblent le suggérer [LN98; Rey61; Mac76; Kam67; KM96; Res99].

Pour finir, nous avons pris le parti d’utiliser l’apprentissage par renforcement, utilisé dans le conditionnement instrumental, comme base de nos travaux et de l’étendre au concept des représentations factorisées présent et nécessaire au cadre Pavlovien. Une autre approche aurait pu être de prendre pour base un modèle du conditionnement Pavlovien, comme par exemple les travaux sur la Latent Cause Theory [Cou+04; Cou+06; GN12] et de l’étendre avec des notions nécessaires au conditionnement instrumental comme les actions. Cette approche a notamment été utilisée par Cartoni et al. [Car+13] pour rendre compte de certains phénomènes d’interactions entre instrumental et Pavlovien. Dans les deux cas, cette approche soulève la question de la différence entre réponses/réflexes condi-tionnées et actions volontaires [Bal+08].

Cette thèse est une petite étape dans le développement d’un cadre unifié pour l’étude des conditionnements Pavlovien et instrumental, et particulièrement pour l’étude des tâches expérimentales qui les impliquent tous les deux. En prenant inspiration de différences inter-individuelles et de comportements inadaptés observés dans le conditionnement des rats et des pigeons, nous avons pu extraire deux concepts qui semblent importants pour ce conditionnement : la combinaison de plusieurs systèmes d’apprentissage par renforce-ment et le traitement individuel des stimuli ainsi que leur compétition. L’interprétation d’autres données expérimentales pourrait bénéficier de cette approche. Nous espérons que poursuivre cette démarche apportera de nouvelles idées dans le domaine.

Motivations

Computational models are determinant tools in the scientific study of the nervous sys-tem [Day94]. They help to synthesize large quantities of empirical data in all disciplines of neuroscience, from studies at the molecular level to studies at the behavioural level. Theories regarding the mechanisms and functional roles of the various elements of the nervous system, e.g. anatomical parts or specific chemicals, or even more general capaci-ties, e.g. memory, are often validated afterwards, suggested beforehand and/or formalized by computational models. They allow one to replicate results, to explain findings with simple notions, to draw predictions and to guide research processes towards important questions.

Computational neuroscience is of particular interest for studying how one learns from its interactions with the world, anticipates future events and ultimately selects and/or produces actions. Among these capacities one can distinguish between Pavlovian and instrumental conditioning. Pavlovian conditioning [Pav27] consists in the acquisition of responses towards neutral stimuli that have been paired with rewards, such as when one salivates at the bell of the ice cream truck. Instrumental conditioning [Ski38] consists in the expression of a behaviour in order to achieve a goal, such as when one learns to dial a specific number on a phone to call someone. Combined together these mechanisms are at the heart of our learning capacities and their study significantly benefits from computational models.

Reinforcement learning (RL) [SB98], in short learning by trials and errors to decide which action to take in a given situation to achieve a specific goal, is one of the major frameworks used in the current computational models of Pavlovian and instrumental con-ditioning. As an example of its deep contribution in the expansion of Pavlovian condition-ing, the learning algorithm TD-Learning [SB81], first developed to explain the prediction capacities of animals in some experimental task, was subsequently shown to rely on a signal that could be paralleled with the activity of some dopaminergic neurons during the experimental task [Sch+97]. Hence, TD-Learning successfully linked the expression of a behaviour with some possible underlying neural correlates. With the accumulation of evidences, it is now well accepted that conditioning results from the combination of some kind of reinforcement learning processes.

Surprisingly, while early used in the investigation of Pavlovian conditioning, the mod-ern RL framework is more suited for the investigation of instrumental conditioning, where actions are indeed required to achieve goals. Recent computational models of instrumen-tal conditioning are often the result of a combination of multiple RL systems [Daw+05; Ker+11; Pez+13]. However, recent computational models of Pavlovian conditioning do not rely much more on this general framework but on more specific architectures [Sch+96; MM88; Cou+04; SM07; Jam+12; Has+10]. This is a problem when one investigates the interactions between both types of conditioning as the combination of the various com-putational models is often not straightforward nor natural.

Objectives

In the present thesis, we aim at finding key concepts that could be used in RL compu-tational models to allow the study of Pavlovian conditioning, instrumental conditioning and their interactions. Taking inspiration from a variety of experimental data, our in-tuition is that combining dual-learning and factored representations may help to explain experimental data yet unaccounted for. Dual learning is a commonly accepted concept in the study of instrumental conditioning while factored representations are a concept ne-glected in RL algorithms of conditioning but often present in the alternative architectures developed to account for Pavlovian conditioning. Especially, we investigated some experi-mental data about behavioural inter-individual differences in rats undergoing a Pavlovian conditioning task and other experimental data about maladaptive behaviours expressed by pigeons in a supposed interaction task, that could well be explained by such concepts.

In order to address these issues, the work presented in this thesis is grounded on a multidis-ciplinary approach, combining tools or data from neuroscience and artificial intelligence.

On the neuroscience side, we took inspiration from experimental data about mal-adaptive behaviours and inter-individual variability in conditioning tasks, including be-havioural, neurophysiological, neuropharmacological and neuropsychological data. Be-havioural analyses involve the observation of animals behaviours in experimental task to investigate their response properties, their capacities, their limits and the strategies developed. Neurophysiology consists in recording the activity of brain regions and/or par-ticular cells, using various techniques such as functional Magnetic Reasonance Imaging (fMRI) or Fast Scan Cycling Voltammetry (FSCV). It helps to investigate the signals on which might rely learning processes that lead to the observed behaviours and locate where values, variables or associations might be stored. Neuropharmacolocy studies the effect of drugs on the nervous system. By injecting drugs that affect specific cells or chemicals, e.g. dopamine, either locally or systemically, it helps to investigate their functions and contributions in the observed behaviours. Similarly, neuropsychology studies the effect of lesions of parts of the brain to identify which and how brain areas contribute to the different aspects of particular behaviours.

On the artificial intelligence side, we mainly use computational models based on ma-chine learning and evolutionary algorithms. Machine learning, from which reinforcement learning algorithms are a subset, are algorithms designed to learn from data in a wide diversity of manners for as many different purposes. In our case, we use it mainly to learn how to successfully accumulate rewards in an efficient way. Evolutionary algorithms are population-based metaheuristic optimization algorithms that can be used to tune algo-rithms to fit as closely as possible some particular behaviours or results.

In the present work, we first investigated experimental data about conditioning, col-lected by different approaches, from which we extracted challenging data for the current literature and hints about the mechanisms they might be the result of. Then we developed a computational model with such mechanisms, tuned it with evolutionary algorithms and confronted it to the data for validation.

Organization

ditioning task that are conflictual with the current literature. Chapter 6 extends the first one with detailed predictions drawn from the model through new simulations in pro-posed variants of the original experimental protocol. Chapter 7 shows some generalization abilities of the computational model by applying it to another set of experimental data suggesting inter-individual variability in a different conditioning task about maladaptive behaviours. Each chapter begins with a short introduction that outlines the content of the article and how it is related to the present work.

Finally, Chapter 8 details our contributions, their limits, discusses our architecture choices, and give possible directions for future research.

Table of contents :

1 Introduction

1.2 Objectives

1.3 Methods

1.4 Organization

2 Reinforcement learning

2.1 Introduction

2.2 Markov Decision Processes

2.3 Reinforcement learning

2.4 Extensions of the classical framework – Factored representations

3 Animal conditioning

3.1 Introduction

3.2 Instrumental conditioning

3.3 Pavlovian conditioning

3.4 Pavlovian-instrumental interactions

4 Synthesis and working hypothesis

5 Modelling individual differences in autoshaping CRs (article)

6 Predictions from a computational model of autoshaping (article)

Abstract

Introduction

Material and methods

Results

Discussion

7 Model of individual differences in negative automaintenance (article)

Abstract

Introduction

Methods

Results

Discussion

8 Discussion

8.1 Contributions synthesis

8.2 Limits and perspectives

8.3 Concluding remarks