Get Complete Project Material File(s) Now! »

Effets séquentiels et réseaux attracteurs

Les expériences typiques pour l’étude de la prise de décision consistent en une série d’essais successifs qui sont séparés par un court intervalle de temps. De nombreuses études ont mis en évidence la dépendance séquentielle dans les décisions perceptuelles. Dans cette section, je m’intéresserai à ces différents effets en proposant une modélisation à l’aide d’attracteurs neuronaux.

Dynamique de relaxation

Je considère un réseau neuronal récurrent qui simule un processus de décision grâce à de l’excitation récurrente et de l’inhibition. Le modèle est constitué de deux populations excitatrices qui sont sélectives pour une des deux catégories (correspondant au mouvement des points du RDM). Les deux populations s’inhibent l’une l’autre et sont soumises à une excitation récurrente. La dynamique consiste en une dynamique non-linéaire entre deux attracteurs (Wong and Wang, 2006; Berlemont and Nadal, 2019). Lors des tâches de prise de décision les neurones montrent une décroissance rapide de leur activité après que les sujets aient répondu(Roitman and Shadlen, 2002; Ganguli et al., 2008). Pour obtenir ce comportement dans le réseau à attracteur, il est nécessaire d’introduire une courte période de relaxation entre chaque essai. Je propose de modéliser cette période à l’aide d’un bref courant inhibiteur qui permet la décroissance de l’activité.

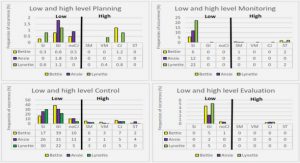

La figure 1.6 décrit le comportement du modèle attracteur lorsqu’il est soumis à un courant inhibiteur. Dans le cas d’un courant constant dans le temps (Figure 1.6 A-B-C-D), si le courant est trop faible, le système est inchangé. Si le courant est suffisamment fort, une bifurcation a lieu et seul un point fixe existe à présent. Pour un tel courant inhibiteur, le système est donc réinitialisé dans un état neutre en ayant perdu la mémoire de son état précédent. Dans le cas d’un courant dépendant du temps (Figure 1.6 E-F-G-H), le réseau voit sa dynamique de relaxation ralentie au cours du temps. La première partie de relaxation, rapide, permet de quitter l’état attracteur puis la seconde partie permet de garder une sorte de mémoire de l’état précédent.

Effets séquentiels

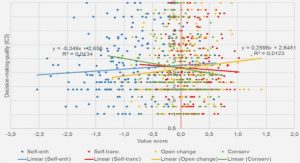

Avec cette relaxation, il est donc possible d’étudier les effets séquentiels observés lors de la prise de décision reproduits par les réseaux attracteurs. J’ai commencé par l’analyse des effets dits de biais séquentiels: les décisions sont biaisées vers la décision précédente lorsque les choix sont effectués en séquence. Lors de l’analyse de ce type d’effets dans le modèle, j’ai observé la présence de ces effets avec une variation selon le temps de relaxation (F) Représentation plan de phase pour des faibles courants inhibiteurs. (G) Représentation plan de phase pour des forts courants inhibiteurs. (H) Etats attracteurs du système à la fin de la relaxation. A gauche de la ligne grise, le système est bloqué dans sa décision initiale. A droite, le système est capable d’effectuer les décisions les unes à la suite des autres.

entre chaque essai et l’intensité du courant inhibiteur lors de la relaxation. Ceci m’a amené à étudier un autre type d’effet observé lors des expériences psychophysiques: les effets après-erreur (Danielmeier et al., 2011).

Les effets après-erreurs sont nombreux et consistent en des différences entre les temps de réponse et les performances des participants si leurs essais sont regroupés en deux groupes: les essais qui suivent des erreurs et les essais qui suivent des décisions correctes. L’effet le plus étudié expérimentalement consiste en le ralentissement après-erreur (PES). Les temps de réponse après une erreur sont plus longs que les temps de réponse après une décision correcte. De manière surprenante, cet effet est présent dans les tâches de décision où le participant n’est pas informé de l’exactitude de sa réponse.

Le modèle de réseau attracteur reproduit les effets après-erreur (Figure 1.7). Il met également en évidence une certaine région de paramètres où, au lieu d’un ralentissement après-erreur, le réseau montre une accélération après erreur. Il est important de noter que cet effet a également été observé chez les participants, qu’il s’agisse de singes ou d’humains.

Figure 1.7: Ralentissement après-erreur dans le modèle pour un intervalle entre stimuli de 500 ms. (A) Diagramme de phase de l’effet PES. La zone inférieure blanche correspond aux paramètres pour lesquels la prise de décision en séquences n’est pas possible. Les carrés rouges correspondent à l’effet PES et en bleus à l’effet opposé. Les zones noires correspondent aux zones où les panneaux (B) et (C) zooment.

Jusqu’à présent il semblait contradictoire avec l’effet PES. Dans ce travail, j’ai montré que bien que ces deux effets soient opposés, ils peuvent être obtenus par le même système de prise de décision.

Dynamique non-linéaire

Pour reproduire les conditions expérimentales, le réseau neuronal ne reçoit aucune informa-tion sur sa réponse. Ainsi, l’effet après-erreur observé ne peut pas provenir d’interférences d’éléments externes. Il est surprenant qu’un tel système puisse exhiber, dans ces conditions, tous ces différents effets après-erreur. Cependant, ceci peut s’expliquer par la dynamique non-linéaire du modèle (Figure 1.8).

Si la décision est répétée (Figure 1.8.A et B), à la fin de la relaxation du système, les deux dynamiques après-erreur et après-correct se situent à l’intérieur du bon bassin d’attraction. Ainsi les taux d’erreurs de ces essais sont similaires. Cependant, les états atteints à la fin de la relaxation sont différents. Comparé à l’essai après-erreur, l’essai après-correct se situe plus proche de la frontière du nouvel attracteur associé à la décision suivante; ainsi cette nouvelle décision sera plus rapide. Dans le cas d’une alternance de réponse (Figure 1.8 C et D), les états atteints à la fin de la relaxation ne sont pas dans le bon bassin d’attraction. Pour l’essai après-correct, la dynamique est assez directe pour passer à travers la frontière; la décision est donc rapide. Pour le cas après-erreur, il s’agit du comportement opposé. Ainsi, c’est bien la dynamique non-linéaire du modèle qui explique les différents effets après-erreur qu’il reproduit.

Table of contents :

1 Résumé substantiel en français

1.1 Introduction

1.1.1 La prise de décision en sciences cognitives et neurosciences

1.1.2 Modèles de prise de décisions

1.2 Effets séquentiels et réseaux attracteurs

1.2.1 Dynamique non-linéaire

1.3 Modélisation de la confiance

1.4 Apprentissage d’un tâche de catégorisation et confiance

1.5 Méthode de la cavité pour les réseaux neuronaux

2 Introduction to decision-making

2.1 Decision-making in cognitive science and neuroscience

2.2 Models of decision-making

2.2.1 Drift-diffusion model

2.2.2 Recurrent cortical circuit

3 Sequential effects and attractor neural networks

3.1 Repetition biases

3.1.1 Cognitive aspect

3.1.2 Neural correlates of sequential effects

3.1.3 Models of sequential effects

3.2 Post-error effects

3.2.1 Experimental evidences

3.2.2 Post-error adjustments in attractor neural networks

3.2.3 Non-linear dynamics

4 A cognitive experiment to study confidence

4.1 How to measure confidence experimentally ?

4.1.1 In humans

4.1.2 In animals

4.2 A 2AFC task in humans

4.2.1 Experimental set-up

4.2.2 Behavioral measures

5 Confidence in perceptual decision-making

5.1 Models of confidence in perceptual decision-making

5.1.1 Signal detection theory (SDT) framework

5.1.2 Accumulation of evidence framework

5.1.3 Neural substrates of decision confidence

5.2 Confidence reports and attractor neural networks 80

5.2.1 Fitting an attractor network to behavioral data

5.2.2 Confidence model

5.2.3 Sequential effects and confidence

5.2.4 Attractor neural networks vs. other models

II Neural coding

6 An overview of categorical perception

6.1 Categorical perception

6.1.1 Categorical perception

6.1.2 Neuronal evidence

6.2 Population coding 98

6.2.1 Fisher information

6.2.2 Top-down feedback

7 Learning a categorization task: the impact of confidence

7.1 Coding and Decoding during a categorization task

7.1.1 Probabilistic framework

7.1.2 Recurrent neural network framework

7.2 Confidence-modulated Hebbian learning

7.2.1 Two-layers model

7.2.2 Learning the categorization task

III Mean-field equations of neural networks

8 Mean-field equations of neural networks

8.1 Temporal dynamics of neural networks

8.2 Dense strongly coupled partially symmetric networks

8.2.1 Mean-field solution

8.2.2 Stability

8.3 Rectified linear transfer function

8.3.1 Steady-state of the network

8.3.2 Stability of the fixed point

8.3.3 Beyond the bifurcation

9 Conclusion and Perspectives